不到1万块钱!4张显卡!64G显存!手搓水冷4卡V100服务器教程

作者: 二把刀程序员

发布时间: 2025年06月14日 16:05

地点: 北京

前言

最近手搓了一台4张显卡,64G显存,能运行70b DeepSeek的服务器,大模型输出的性能达到25tokens/s,非常流畅。真的是手搓,手指头搓的指甲和肉分离了,现在好几天了还有点疼!所以不能白干啊,把这个教程分享给大家。

装配完成的4卡V100服务器

装配完成的4卡V100服务器

硬件配置清单

| 组件 | 型号/规格 | 说明 |

|---|---|---|

| 主板 | 7048GR (超微) | 台湾厂商超微的主板,H100,H200等高端显卡也都使用 |

| 显卡 | Tesla V100 × 4 | 每张16G HBM2显存,总计64G显存 |

| 电源 | 2000W | 多显卡机器必须大功率电源 |

| 散热 | 480冷排水冷系统 | 外置安装 |

| 转接卡 | SXM2转PCIE × 4 | V100专用转接卡 |

注意: 主板是7048GR,这是台湾厂商超微的主板,H100,H200等高端显卡也都是用的这一家的主板。网上买的二手服务器品牌可能是浪潮也可能是曙光,但主板都是这个,外壳也都相似。

为什么选择V100?

性能表现

V100曾经是数据中心的计算王者,IBM用这个显卡制造的超级计算机Summit曾经是超算的世界第一。如今从数据中心退役飞入寻常百姓家,但性能依然强劲:

- 计算能力: 相当于RTX 2080Ti

- 显存容量: 每张16G HBM2高带宽显存

- 整体性能: 4张V100计算能力相当于RTX 4090,但显存远超4090

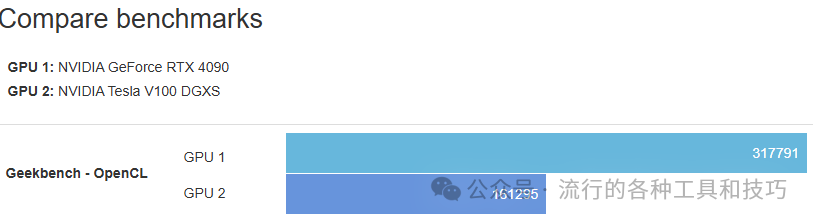

性能对比

GeekBench OpenCL测试:一张4090约等于两张V100

GeekBench OpenCL测试:一张4090约等于两张V100

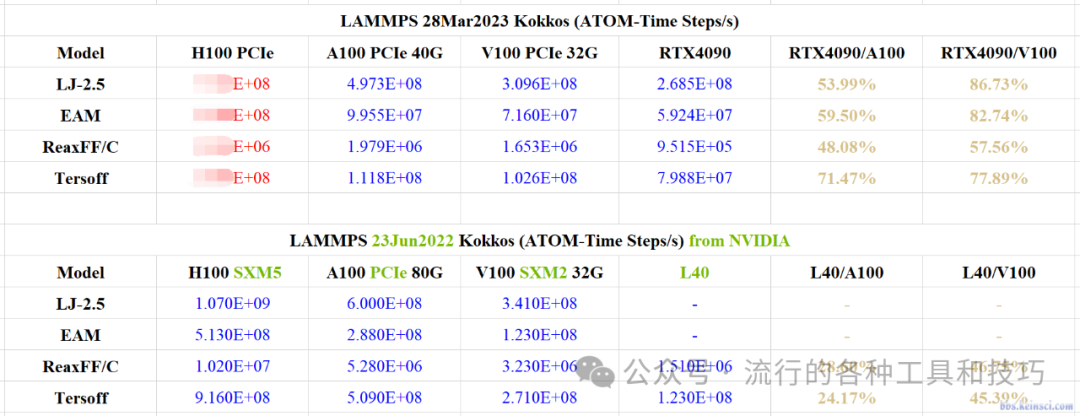

在不同应用场景下,V100与4090的表现对比:

计算化学应用场景下,4090运行某些计算包还不如V100

计算化学应用场景下,4090运行某些计算包还不如V100

性价比优势

V100绝对是当前显卡界的性价比王者。但用好这张显卡并不容易,因为:

- 接口问题: 显卡为数据中心而生,接口是SXM2,需要转接卡

- 散热要求: 功耗较高(每张最大300W),对散热要求很高

- 安装复杂: 需要手工改造和精细安装

散热方案选择

功耗计算

- 每张V100显卡最大功率: 300W

- 4张显卡总功耗: 1200W

- 散热需求: 估算240冷排可带两张,4张需要480冷排

实际安装

到货后发现480冷排体积确实太大了,装不到服务器内部,只能外置安装。

外置480冷排散热系统

外置480冷排散热系统

安装过程详解

转接卡安装

SXM2转PCIE转接卡原始状态

SXM2转PCIE转接卡原始状态

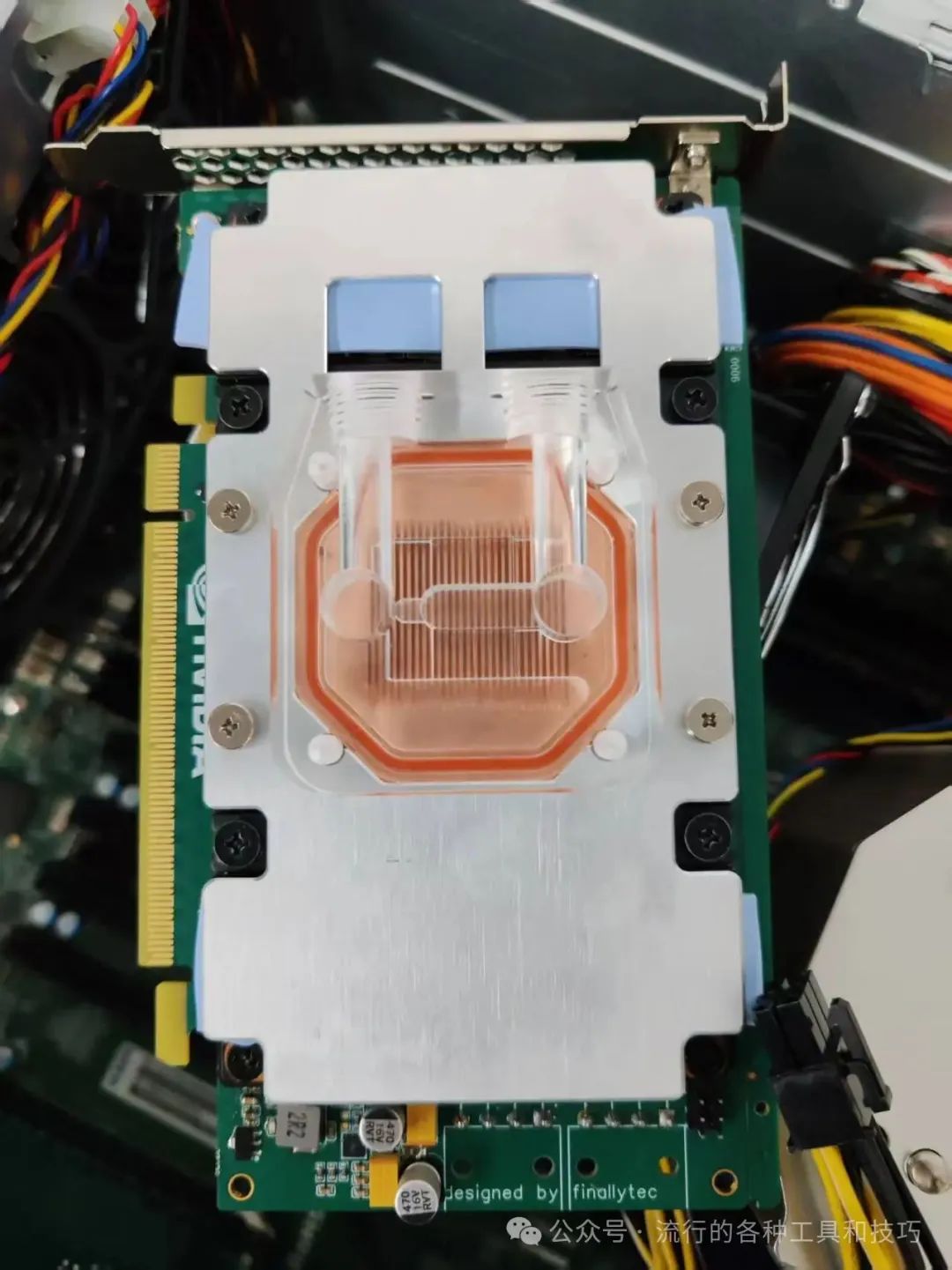

每张V100显卡需要加装: - SXM2转PCIE转接卡 - 定制水冷头

安装完转接卡和水冷头的V100显卡

安装完转接卡和水冷头的V100显卡

机箱内安装

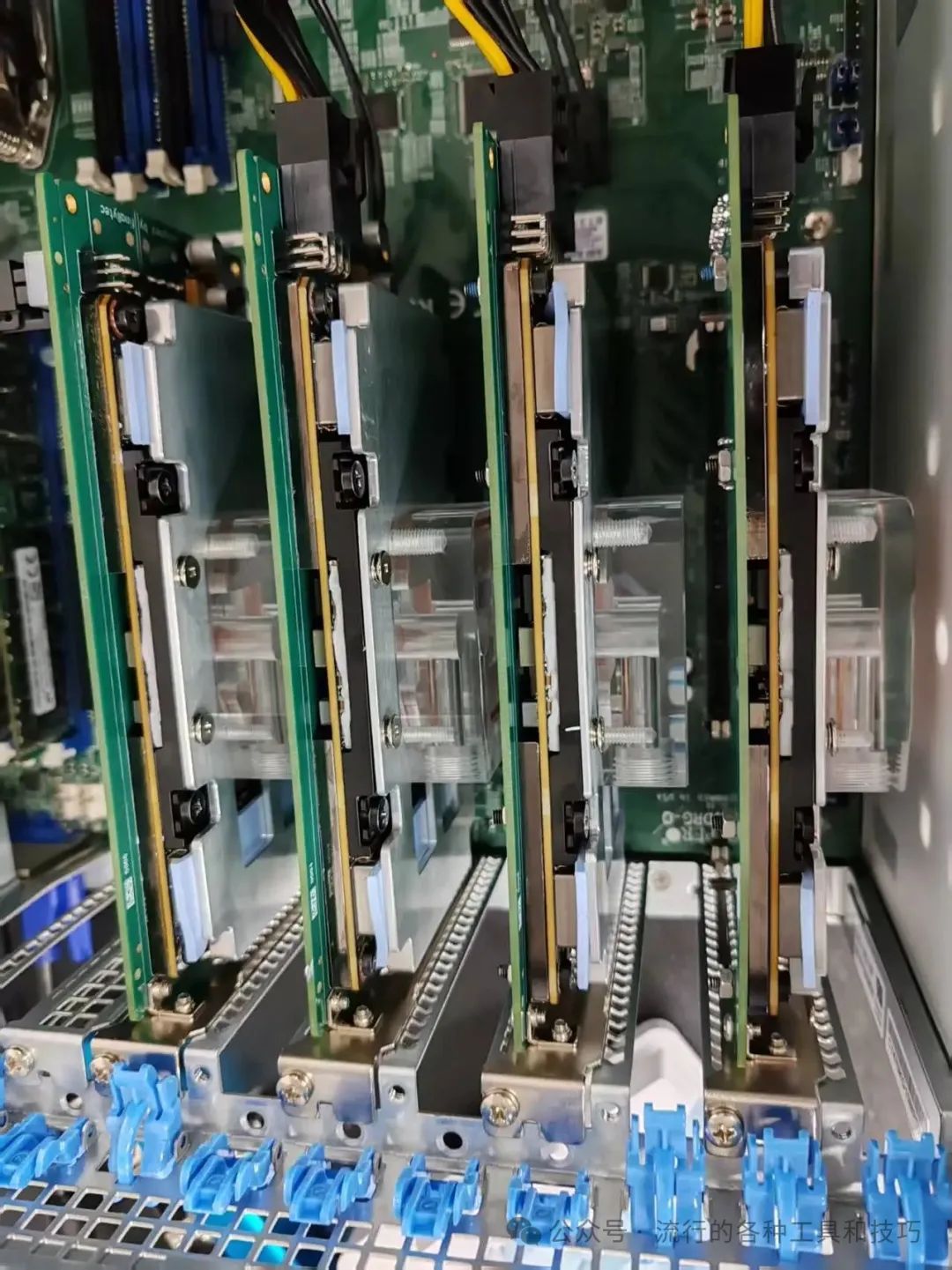

四张V100在机箱内的最终安装效果

四张V100在机箱内的最终安装效果

四张卡并排安装还有一点空隙,水冷占用空间相对较小。但在装水管时,真的需要手工精细操作,安装过程比较困难。

温度测试

水冷未完全安装时的温度监控,约50多度

水冷未完全安装时的温度监控,约50多度

安装完成后的温度表现: - 空载状态: 接近室温 - 高负载运行: 每张卡200多W功率下不超过60度

性能测试

DeepSeek 32b模型测试

成功运行32b的DeepSeek模型,实际运行效果非常流畅:

性能指标: - 模型: DeepSeek 70b - 输出速度: 25 tokens/s - 运行状态: 非常流畅

总结

这台手搓的4张V100服务器具有以下优势:

硬件优势

- 高性价比: 不到1万元的成本

- 大显存: 64G HBM2显存,适合大模型推理

- 稳定性能: 数据中心级别的硬件可靠性

适用场景

- 个人AI开发者

- 中小企业AI应用

- 科研院所和课题组

- 大模型本地化部署

技术特点

- 支持70b参数大模型

- 推理速度达到25tokens/s

- 温控优秀,长时间稳定运行

后续计划

如果大家需要更详细的安装教程,我可以分模块详细介绍: - 硬件选型和采购指南 - 详细的安装步骤 - 系统配置和软件环境搭建 - 性能调优和故障排除

如果你也想要这样一台高性价比的AI服务器,欢迎联系作者获取更多技术支持和定制服务!

本教程展示了如何以极高的性价比搭建专业级AI计算服务器。虽然安装过程需要一定的动手能力,但最终获得的性能和成本优势是值得的。对于需要大显存、高计算能力的AI应用场景,V100依然是一个优秀的选择。

联系作者